Fokus Crawling

Tujuan dari web crawling adalah untuk mengumpulkan koleksi halaman web

yang berguna secepat dan seefisien mungkin, sambil memberikan

setidaknya fitur yang diperlukan untuk menghormati keterbatasan yang

ditetapkan oleh penerbit (kesopanan) dan menghindari perangkap

(ketahanan).

Dhinakaran dan Sambanthan [7] memberikan gambaran singkat tentang

empat kebijakan yang kombinasi yang mempengaruhi perilaku web crawler. Kami mewarisi dari sebuah implementasi crawler yang ada untuk

menentukan kebijakan untuk mengunjungi kembali, paralelisasi, dan

kesopanan.

Kami terutama akan fokus pada pelaksanaan kebijakan pilihan baru, yaitu menentukan urutan URL baru yang ditemukan dan diproses. Kebijakan

Pemilihan web crawler biasanya menggunakan variasi dari algoritma

PageRank [24] dengan tujuan untuk mengumpulkan halaman yang paling

populer dalam Web, karena mereka juga lebih mungkin untuk mencari. Meskipun menurut definisi semua crawler bertujuan untuk membangun

koleksi yang berguna untuk tujuan tertentu, fokus crawler seperti yang

dijelaskan di halaman sasaran literatur yang relevan dengan topik

tertentu.crawler fokus pertama kali disebutkan oleh Menczer [20] yang

dimodelkan masalah terinspirasi oleh bekerja pada agen beradaptasi

dengan lingkungan yang berbeda.

Kemudian, Chakrabarti et al. menciptakan crawler jangka fokus dan memperkenalkan pendekatan

menggunakan pra dilatih classifier untuk menetapkan topik-label ke URL

baru berdasarkan fitur yang dapat diekstraksi dari URL itu sendiri [4]. Fitur klasifikasi lainnya telah diperoleh dengan menggunakan teknik NLP yang berbeda [13, 14, 16, 27]. Selanjutnya, Rajin et al. menggunakan informasi yang dikumpulkan dengan menggunakan mesin

pencari web untuk mengumpulkan fitur tambahan untuk klasifikasi [?].

Aggarwal et al. Informasi

dimasukkan dikumpulkan selama merangkak untuk mengarahkan arah crawler

dan memaksimalkan jumlah diambil halaman yang relevan [?]. Mereka

menggunakan fitur diekstrak dari isi ayah dari halaman (yaitu halaman

di mana kami menemukan link), mengambil token fromunseen string URL dan

fitur yang dikumpulkan dari halaman saudara (yaitu yang URL ditemukan di

halaman yang sama sebagai salah satu yang akan merangkak).

Setelah crawling halaman, kemungkinan kelompok fitur yang berbeda untuk suatu topik tertentudievaluasi dan probabilitas gabungan digunakan untuk memperbarui prioritas halaman tak terlihat.Meskipun model ini memanfaatkan fitur yang dikumpulkan selama proses

merangkak, model probabilistik perlu disesuaikan secara manual terlebih

dahulu, yang Chakrabati et al.mencoba untuk mengatasi ketika pertama kali memperkenalkan pendekatan klasifikasi online untuk fokus merangkak [?].

Chakrabarti et al. dibuat

dua pengklasifikasi, satu statis, pretrained dari dimuka dikumpulkan

dan ditandai corpus, dan satu online, yang digunakan untuk meningkatkan

mantan keputusan berdasarkan fitur diekstraksi dari dokumen model objek,

misalnya jangkar teks dalam link dari halaman merangkak. Empat tahun kemudian, Barbosa dan Freire mengambil ide utama

menggabungkan informasi yang dikumpulkan selama merangkak untuk

mengarahkan crawler dengan diperpanjang set fitur [?].

Selain

konteks halaman di mana URL ditemukan, mereka membuat penggunaan

grafik-struktur halaman web, misalnya dengan membedakan antara fitur

langsung diambil dari ayah dan saudara kandung dari halaman, yang

kemudian juga digunakan oleh Zheng et Al. [32].Meskipun mereka menggabungkan informasi yang dikumpulkan selama

merangkak, mereka hanya mengganti classifier mereka dengan versi terbaru

dalam batch, hanya menggunakan informasi baru yang dikumpulkan dan

membuang informasi sebelumnya diekstrak.Hasil penelitian mereka menunjukkan bahwa secara berurutan diperbarui pengklasifikasi menyebabkan tingkat yang lebih tinggi dari

mengumpulkan formulir web untuk domain topikal tertentu. Umbrich et al. mengusulkan pendekatan berbasis pola untuk mengklasifikasikan halaman, untuk menemukan jenis media tertentu di Web [30]. Jiang et al. [12] menggunakan metode yang sama untuk belajar pola URL yang mengarah ke halaman yang relevan di forum web.

Perbedaan utama dari pekerjaan ini sehubungan dengan arus utama

difokuskan merangkak adalah bahwa kita tidak bertujuan untuk melakukan

klasifikasi berdasarkan topik-, melainkan melihat nilai dari halaman web

dari perspektif data yang dikandungnya. halaman web yang menyajikan data terstruktur memiliki karakteristik yang unik; markup terstruktur lebih umum untuk jenis tertentu dari halaman, misalnya itemdetail halaman, dan disukai oleh situs web tertentu, biasanya

besar situs yang dihasilkan secara dinamis menyajikan jenis konten

tertentu.

Target kami juga berbeda dari yang perayap web semantik asli yang

mengumpulkan dokumen dalam format dokumen RDF, yang mengikuti seeAlso

dan sameAs referensi untuk item data yang terkait dalam rangka untuk

menemukan sumber data baru terkait dan informasi.Dua contoh adalah Slug dan LDSpider [9, 11]. crawler

ini berurusan dengan isu-isu spesifik terkait dengan data RDF di Web

seperti dukungan untuk berbagai format RDF asli, mendukung berbagai

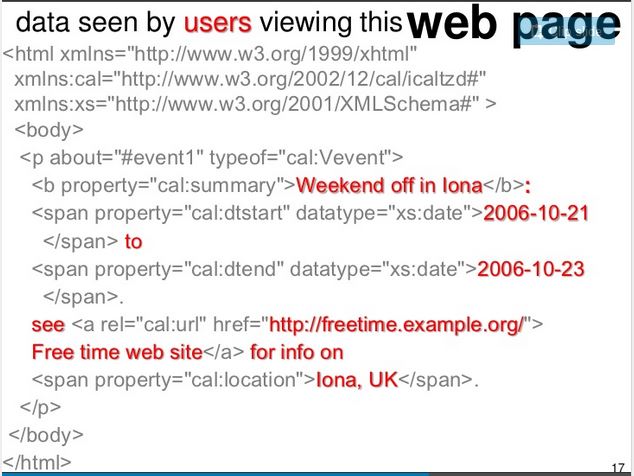

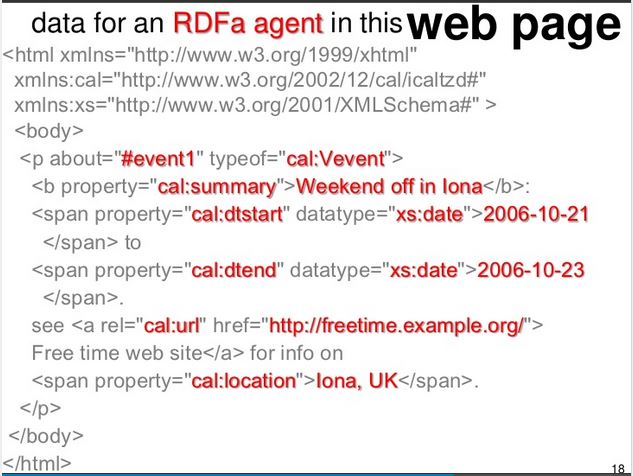

protokol komunikasi dll Sebaliknya, pekerjaan kami berfokus pada data

terstruktur tertanam di dalam halaman HTML yang baru-baru ini telah

berkembang menjadi lebih populer cara mengekspos data pada Web.

Studi

terbaru menunjukkan meningkatnya ketersediaan dan keragaman data

terkena cara ini [2, 22], menawarkan sumber data yang tersedia secara

publik luas dengan potensi besar untuk berbagai aplikasi.